Un peu d’histoire

Et la réponse était bien 1956 !

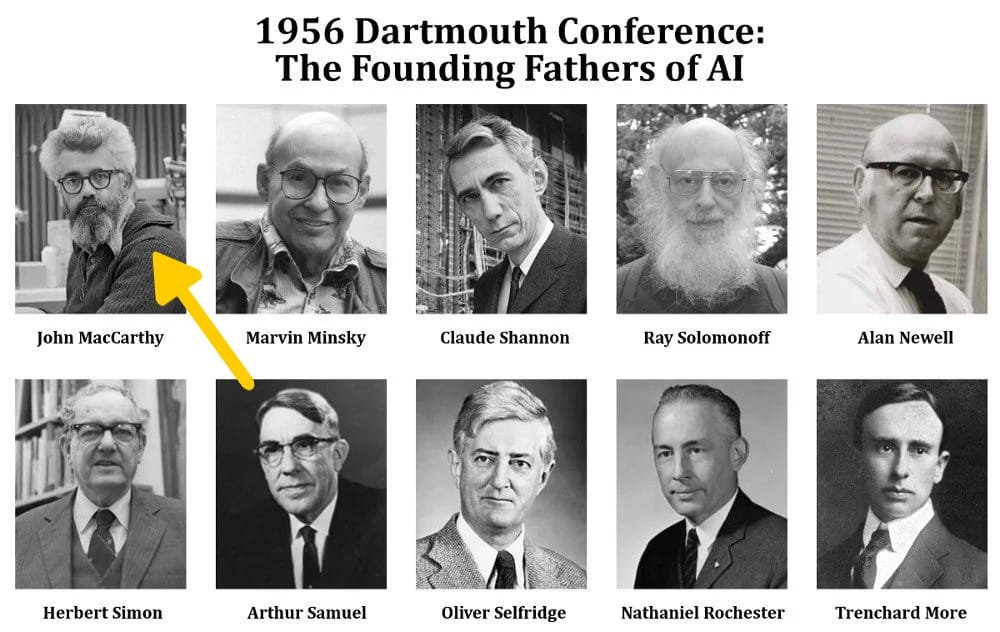

La conférence de Dartmouth (Dartmouth Summer Research Project on Artificial Intelligence) est un atelier scientifique organisé durant l’été 1956, qui est considéré comme l’acte de naissance de l’intelligence artificielle en tant que domaine de recherche autonome.

Organisée par Marvin Minsky et John McCarthy, elle a eu lieu sur le campus du Dartmouth College (aux Etats-unis) et a réuni vingt chercheurs.

C’est à l’occasion de cette conférence que McCarthy a convaincu l’auditoire d’accepter l’expression « Intelligence Artificielle » comme intitulé du domaine

John Mc Carthy y présenta notamment le principe d' »élagage alpha-bêta« , considéré comme le premier algorithme de programmation en intelligence artificielle.

À cette époque, bien que les ordinateurs étaient énormes et très limités, ces chercheurs étaient convaincus qu’en une décennie, les machines seraient capables de jouer aux échecs comme des maîtres, traduire des langues, et même résoudre des problèmes mathématiques complexes.

Source : https://fr.wikipedia.org/wiki/Conf%C3%A9rence_de_Dartmouth

Mais que veut dire Intelligence Artificielle 🤔 ?

L’intelligence artificielle (IA) est un domaine de l’informatique visant à créer des systèmes capables de réaliser des tâches en simulant l’intelligence humaine.

Nous verrons plus tard dans la leçon dédiée comment fonctionne l’IA, mais en attendant, ce qu’il faut retenir c’est que l’IA réalise des tâches en observant et en imitant, puis en améliorant progressivement ses compétences grâce à l’expérience qu’elle aura développée.

Si vous avez besoin de définitions ou de réponses courtes et rapides sans avoir à chercher dans plusieurs sites, je vous recommande d’utiliser l’IA du site perplexity.ai, très pratique (et gratuit ! )

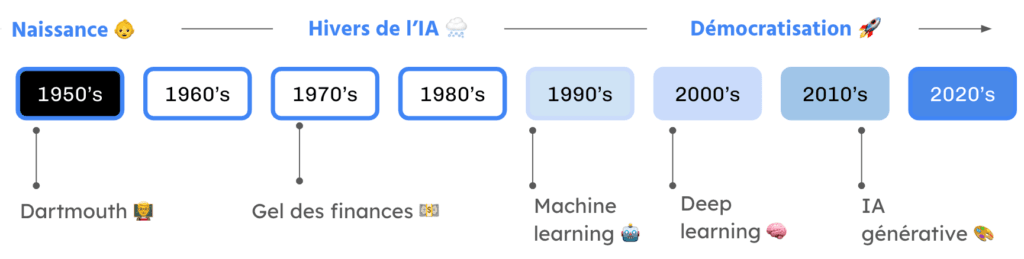

La question qui se pose, c’est : ça fait presque 70 ans que ça existe, mais pourquoi est-ce que l’on entend parler de l’IA depuis quelques années seulement ?

Les Premières Années et le Premier Hiver de l’IA (1974-1980)

Les premières recherches en IA ont connu des succès prometteurs, avec la création de programmes capables de jouer aux échecs, résoudre des problèmes de mathématiques, et même comprendre le langage naturel de manière limitée.

Par exemple, un programme appelé ELIZA permettait déjà simuler (de manière très basique) une conversation avec un psychothérapeute.

Cependant, ces programmes avaient leurs limites. Les ordinateurs de cette époque manquaient de puissance, et les programmes étaient incapables de s’adapter à de nouvelles situations.

Avec des attentes démesurées et des résultats limités, le financement et l’intérêt pour l’IA ont commencé à décliner. Les gouvernements et les entreprises ont réduit leurs investissements, menant au premier « hiver de l’IA ».

Le Renouveau des Années 80 et le Deuxième Hiver de l’IA (1987-1993)

Dans les années 1980, l’IA a connu un regain d’intérêt avec les systèmes experts.

Le système DENDRAL par exemple, développé pour aider les chimistes à identifier les structures moléculaires utilisait des règles établies par des experts humains pour analyser des données chimiques.

Ce système trouva des applications pratiques et commerciales, redonnant espoir aux chercheurs.

Cependant, ces systèmes avaient des faiblesses. Ils étaient coûteux à développer et très spécifiques à un domaine… Par exemple, si l’on essayait d’utiliser DENDRAL pour un autre domaine, comme la finance ou la médecine, il fallait tout recommencer de zéro.

De plus, ces systèmes atteignaient rapidement leur limites, ils ne pouvaient pas apprendre de nouvelles informations par eux-mêmes.

Ainsi, quand les entreprises se sont rendu compte que les coûts de développement étaient trop élevés par rapport aux bénéfices, elles ont de nouveau réduit leurs investissements, provoquant un deuxième hiver de l’IA à la fin des années 1980.

Le Printemps de l’IA : Les Années 2000 et l’Explosion du Machine Learning

Le tournant décisif est arrivé dans les années 2000 avec l’essor du Machine Learning (Si vous ne savez pas ce que c’est, demandez à Perplixity 😉).

Plutôt que de programmer des règles explicites, les chercheurs ont commencé à développer des algorithmes capables d’apprendre à partir de données. Cette approche a été rendue possible grâce à trois facteurs principaux :

- L’augmentation massive de la puissance de calcul : Les processeurs sont devenus beaucoup plus rapides et moins chers.

- L’accès à de grandes quantités de données : Internet et les nouvelles technologies ont généré d’énormes quantités de données utilisables pour l’entraînement des algorithmes.

- Les progrès dans les algorithmes d’apprentissage : Notamment les réseaux de neurones profonds, qui ont permis des avancées spectaculaires en reconnaissance d’image, traitement du langage naturel et bien d’autres domaines.

Conclusion

Rappelons nous que les avancées technologiques, comme l’IA, sont souvent accompagnées de périodes de désillusion et de scepticisme. Cependant, avec de la persévérance et de l’innovation, ces périodes peuvent mener à des progrès spectaculaires.

Aujourd’hui, l’IA est devenue un outil puissant qui transforme de nombreux secteurs, et ce n’est que le début !

PS : Si vous vous posez des questions sur un terme un peu technique, jettez un oeil à notre lexique